Dacă aveți suflet bun și vreți să ajutați sau poate dacă visați să vă îmbogățiți rapid, e bine să vă gândiți de două ori înainte să răspundeți unor oferte de pe internet. Nu de alta, dar riscați să rămâneți fără bani.

Poliţia Română atrage atenţia asupra pericolelor inteligenţei artificiale generative, arătând că videclipurile false, create cu AI, au devenit instrumente preferate de autorii infracţiunilor informatice, dar sunt folosite şi pentru manipulare, distrugerea reputaţiei unei persoane, provocarea de traume emoţionale sau inducerea în eroare cu privire la adevăruri ştiinţifice. Poliţiştii fac mai multe recomandări pentru cetăţeni, pentru a nu cădea în astfel de ”capcane”. Ei atrag atenţia asupra unor persoane care se recomandă a fi din Poliţia Română şi care încearcă să inducă în eroare populaţia.

Potrivit Poliţiei Române, inteligenţa artificială (AI) a avansat în ultimii ani, permiţând crearea de videoclipuri şi imagini extrem de realiste. În prezent, aceste tehnologii sunt folosite în principal pentru divertisment, însă un aspect negativ îl reprezintă faptul că acestea sunt utilizate ca un instrument de inducere în eroare a oamenilor, cu scopul de a obţine câştiguri financiare nelegale.

”Deepfake-urile (videoclipuri false create cu AI) şi imaginile generate artificial au devenit instrumentele preferate ale autorilor infracţiunilor din domeniul criminalităţii informatice, promovate masiv pe reţelele de socializare. Cetăţenii de bună-credinţă sunt induşi în eroare de aceste «capcane» crezând că văd celebrităţi, experţi financiari sau persoane aflate la nevoie”, arată sursa citată, într-un comunicat de presă.

Poliţiştii prezintă cele mai frecvente moduri de operare întâlnite în anul 2025:

- Trading scam şi investment fraud

Videoclipuri deepfake cu oameni de afaceri, de notorietate sau cu politicieni care ”recomandă” platforme de investiţii crypto, forex sau ”inteligenţă artificială miraculoasă” care promit multiplicarea banilor peste noapte. Victimele sunt direcţionate către site-uri false unde depun bani spre a fi investiţi şi care, în realitate, ajung la autori prin diferite scheme de transfer de monede (virtuale sau fiat).

- Scam-uri caritabile

Deepfake-uri cu copii bolnavi, victime ale dezastrelor sau celebrităţi care cer donaţii urgente. Oamenii donează, prin intermediul unor link-uri false, iar sumele de bani ajung direct la infractori.

- Romance scam îmbunătăţit cu ajutorul AI

Utilizarea de către infractori a unor profiluri false cu poze şi videoclipuri generate de AI cu persoane atractive din punct de vedere al aspectului şi caracterului, prin intermediul cărora dezvoltă relaţii emoţionale, apoi cer bani pentru ”urgenţe medicale” sau ”bilete de avion”.

- CEO/CFO fraud (Business E-mail Compromise evoluat)

Utilizarea de către infractori de video-call-uri deepfake în care ”şeful” cere transferuri urgente de bani

- Impersonare celebrităţi pentru produse false

Deepfake-uri cu diverse personalităţi care ”oferă gratuit” produse.

”Potrivit statisticilor din anul 2025, tentativele de fraudă cu deepfake au crescut foarte mult pe fondul avansării tehnologiei bazate pe inteligenţă artificială, iar pierderile financiare globale se ridică la zeci de miliarde de dolari, anual”, atrage atenţia Poliţia Română.

Un alt fenomen întâlnit este crearea de imagini cu persoane complet fictive, generate de tool-uri, imagini care sunt perfecte şi descriu persoane frumoase, zâmbitoare, care par 100% reale, dar care nu există în realitate. Poliţiştii afirmă că aceste imagini sunt folosite masiv pentru romance scams şi catfishing, profiluri false de influenceri care promovează produse sau diverse tipuri de înşelătorii sau investiţii, crearea de ”martori” în poveşti false de investiţii (”Uite câţi oameni s-au îmbogăţit!”), şantaj sau hărţuire (poze false cu persoane în situaţii compromiţătoare).

Conform aceleiaşi surse, utilizarea inteligenţei artificiale în scopuri ilegale poate duce la diverse consecinţe, atât din punct de vedere financiar, cât şi din punctul de vedere al manipulării, precum: pierderi financiare directe; traume emoţionale (oameni care donează ultimii bani pentru ”copii bolnavi” inexistenţi sau se îndrăgostesc de persoane false); erodarea încrederii în media şi instituţii: ”Dacă nimic nu mai e real, atunci nimic nu mai contează”; manipulare politică şi electorală (deepfake-uri cu candidaţi care spun lucruri pe care nu le-au spus niciodată); distrugerea reputaţiei personale (revenge porn deepfake, folosit în special împotriva femeilor); ameninţări la securitatea naţională (deepfake-uri cu lideri politici care declară război etc.).

De aceea, Poliţia le recomandă prudenţă cetăţenilor şi oferă mai multe măsuri de contracarare şi protecţie privind recunoaşterea unui videoclip sau o fotografie făcută cu inteligenţa artificială:

Pentru videoclipuri deepfake:

1. Trebuie verificat clipitul ochilor - în multe deepfake-uri vechi, clipitul era anormal, însă, în anul 2025, acest aspect a fost îmbunătăţit considerabil, dar încă apar inconsistenţe;

2. Mişcările buzelor şi sincronizarea cu sunetul - adesea nu sunt perfecte, mai ales în limbi non-engleză;

3. Iluminarea şi umbrele - verifică dacă lumina de pe faţă se potriveşte cu fundalul;

4. Reflexii în ochi şi dinţi - adesea lipsesc sau sunt nenaturale;

5. Mâini şi degete - încă o slăbiciune majoră a multor modele A.I. – aspectul degetelor este anormal, ori sunt prea multe sau prea puţine;

6. Caută artefacte - pete ciudate, blur în jurul feţei, tranziţii nenaturale;

7. Mâini şi degete deformate (apar încă frecvent la deepfake-urile prezente în anul 2025);

8. Fundal inconsistent sau obiecte topite;

9. Ochi asimetrici sau pupile anormale;

10. Păr anormal sau îmbrăcăminte care nu are sens fizic;

11. Aspecte ale unor obiecte sau bunuri din videoclip sau imagine care par deformate;

12. Foloseşte reverse image search (Google Lens, TinEye) – dacă imaginea nu apare nicăieri altundeva înainte de data postării, e suspectă.

Măsuri de protecţie şi prevenire:

1. Regula care se aplică pentru toate măsurile de protecţie împotriva oricărei tentative de înşelăciune: Dacă pare prea frumos ca să fie adevărat (îmbogăţire rapidă, cadouri de la celebrităţi, iubire perfectă în două săptămâni etc.), este fals;

2. Nu da click pe link-uri din reclame sau mesaje nesolicitate;

3. Nu transfera bani niciodată cuiva pe care l-ai cunoscut doar online;

4. Verifică întotdeauna sursa oficială: Dacă un om de afaceri, o persoană de notorietate sau orice altă personalitate promovează ceva, caută pe contul acesteia oficial de pe reţelele de socializare verificat şi vezi dacă a postat acolo;

5. Activaţi autentificarea în doi paşi (2FA) în aplicaţiile şi conturile importante, folosind o aplicaţie de tip ”Authenticator” (nu doar SMS);

6. Este necesară raportarea conţinutului suspect pe platformele pe care apare;

7. Se pot folosi extensii browser care detectează automat deepfake-urile;

8. În cazurile în care aţi fost victima unei înşelăciuni în mediul online, sesizaţi cât mai rapid organele judiciare, întrucât o reacţie promptă poate sprijini în mod semnificativ desfăşurarea investigaţiilor.

De la ”îmbogăţire rapidă” la negarea ştiinţei demonstrate

Poliţia atrage atenţia că, pe lângă scam-urile financiare şi caritabile, infractorii şi grupările de dezinformare folosesc videoclipuri A.I. hiper-realiste pentru a induce în eroare populaţia în privinţa adevărurilor ştiinţifice fundamentale:

- Videoclipuri în care ”astronauţi NASA” mărturisesc în lacrimi că ”aselenizarea a fost filmată în studio” şi că ”Pământul este plat”

- ”Oameni de ştiinţă renumiţi” (de fapt deepfake-uri perfecte) care declară că ”vaccinurile conţin cipuri 5G” sau că ”încălzirea globală este o minciună”

- ”Medici celebri” care recomandă tratamente minune împotriva cancerului cu bicarbonat şi lămâie

- ”Martori oculari” din Ucraina sau Orientul Mijlociu care povestesc atrocităţi inventate, cu feţe şi voci perfect copiate.

”Acestea nu mai sunt doar postări izolate pe grupuri conspirative. În anul 2025, astfel de clipuri ajung în trend pe reţelele de socializare, sunt distribuite de conturi cu sute de mii de followeri şi sunt preluate chiar şi de televiziuni locale care nu verifică sursele”, adaugă Poliţia Română.

Potrivit sursei citate, în ultima perioadă, au fost reclamate mai multe fapte realizate cu inteligenţa artificială, fiind create mai multe videoclipuri false cu un ofiţer de poliţie sau cu alte persoane care se recomandă a fi consultanţi financiari, în vederea inducerii în eroare a victimelor de a realiza investiţii fictive sau a obţine date financiare pentru a putea efectua, ulterior, tranzacţii neautorizate.

”În acest sens, pe lângă recomandările sus-menţionate, facem precizarea că niciodată poliţiştii nu vor apela cetăţenii cu video, prin intermediul anumitor aplicaţii şi cu atât mai mult nu vor face recomandări de investiţii. Totodată, poliţiştii colaborează doar instituţional cu unităţile bancare, în vederea recuperării prejudiciilor sau în cadrul activităţilor desfăşurate şi nu vor face recomandări sau îndrumări cetăţenilor în niciun fel, de genul «urmează să fiţi sunaţi de banca X sau de vreo altă instituţie financiară»”, precizează Poliţia.

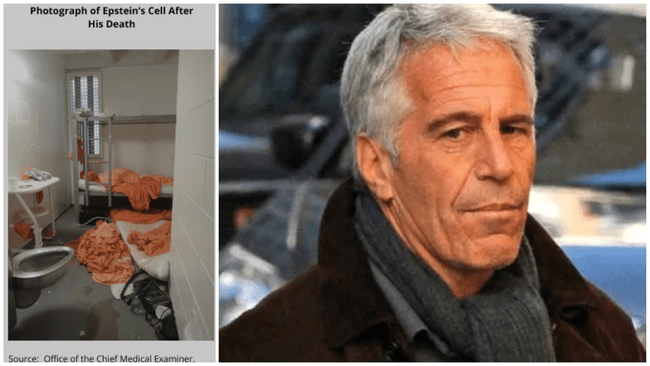

Totodată, instituţia face publice fotografii cu două persoane care se recomandă a fi din cadrul Poliţiei Române, explicând că se poate constata cu uşurinţă că hainele pe care le poartă prima persoană nu reprezintă o uniformă de poliţie, gradele de pe umeri neexistând în cadrul Poliţiei Române, cele reale fiind reprezentate de stele

Comentează